Una de las principales preocupaciones de las entidades financieras hoy en día es la política comercial que deben seguir con sus clientes en las retiradas de efectivo en cajeros a partir del Real Decreto-ley 11/2015, de 2 de octubre, que regula las comisiones por la retirada de efectivo en los cajeros automáticos.

Esta ley surgió de la necesidad por parte del Gobierno de regular lo que se empezó a conocer como “la guerra de los cajeros” y que fue iniciada por CaixaBank cobrando dos euros a los no clientes en marzo de 2015.

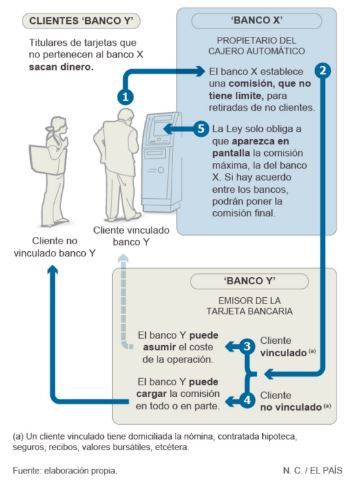

El siguiente gráfico del periódico El País, nos ayuda a entender esta “famosa” ley en el sector bancario de los últimos tiempos:

Con esta nueva situación en el sector surge la necesidad por parte de las entidades financieras de una segmentación avanzada de sus clientes para diferenciar las tarifas comerciales a aplicar en cada caso. En un primer momento, por lo que han optado la mayoría de las entidades es por aplicar los mismos beneficios a todos sus clientes (por ejemplo, 5 retiradas en cajeros distintos a los propios gratis al mes). Estas políticas generalizadas nunca son buenas, tanto para la entidad como para los clientes, que cada uno se comporta de manera diferente.

Con esta situación en la calle, y gracias a los datos que EURO 6000 facilitó a Jose Ramón Cajide (Digital & Big Data Analyst en El Arte de Medir y ahora Data Scientist) y Marta Cámara (Data Scientist en Euro 6000) quienes están detrás de este proyecto, se les ocurrió tratar de hacer una segmentación de clientes en función de su comportamiento en las retiradas de efectivo en cajeros a partir de enero de este año (es decir, el momento de entrada en vigor de la nueva regulación sobre comisiones en cajeros). La incorporación de nuevas fuentes de datos a las segmentaciones tradicionales posibilita la obtención de una visión y un entendimiento más completos de sus clientes. Conocer mejor a los clientes permite realizar un targeting más ajustado, y esto se traduce en mayor eficiencia y rendimiento de las acciones comerciales.

Hoy, juntos, nos cuentan cómo han desarrollado el proyecto, cómo han aplicado lo aprendido en el Máster de Data Science y lo comparten con nosotros:

Desde un principio los dos teníamos claro que queríamos aplicar a nuestro proyecto todo aquello que habíamos aprendido durante el máster, tanto en lo que respecta al empleo de una metodología para la gestión del proyecto como en la combinación de parte de las herramientas y modelos.

Comenzamos tratando de entender el ámbito, conocer el negocio en el que íbamos a centrar nuestro proyecto. Esta es una de las cosas que te enseña Israel Herraiz (director del máster) el primer día de clase y es un factor crítico para alcanzar el éxito en cualquier proyecto de data science.

Esto te facilita el identificar el enfoque analítico a seguir, los métodos estadísticos o de aprendizaje automático (machine learning) que nos ayudarían a dar respuesta a la pregunta de negocio que nos planteamos inicialmente.

A partir de aquí comenzamos por obtener los de datos para el proyecto. Fue un proceso que se repitió hasta que conseguimos la información que necesitábamos para ser analizada.

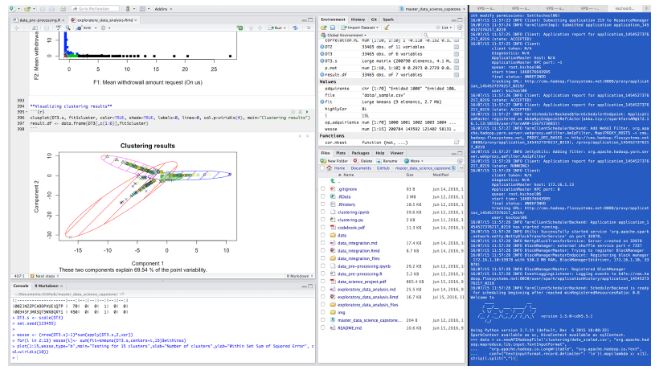

Comenzamos entonces la parte más laboriosa en la que tratamos los datos y realizamos un minucioso análisis exploratorio de los mismos. Aunque esta parte fue ejecutada en su mayor parte usando lenguaje R, no dejamos de utilizar los conocimientos aprendidos para el manejo de datos mediante la línea de comandos de Linux (bash) así como de alguna librería en Python.

Seguimos con un proceso de transformación de los datos, tomando ciertas variables existentes y generando nuevas a partir de las ya existentes para posteriormente realizar aquellos test estadísticos que nos informaban de la variables que debíamos considerar y cuáles excluir.

A continuación iniciamos la fase de modelado, es decir, aquella en la que se trata de dar forma a los datos Es la fase en la que tratamos de encontrar tras realizar pruebas con nuestros equipos y dado el volumen de datos que teníamos y la complejidad de los cálculos, optamos por utilizar el cluster al que teníamos acceso. Esta fase suponía un desafío para nosotros pero nos sirvió para aprender a desarrollar una aplicación en Python haciendo uso de la api para Spark (Pyspark) y a implementar un algoritmo de aprendizaje no supervisado sobre un entorno en el que los datos se encontraban distribuidos en varios nodos de servidores Hadoop.

Una vez evaluado el modelo y finalizamos con la visualización del resultado. Durante el máster aprendimos a realizar potentes visualizaciones con R, D3.js, Tableau e incluso Python. Las clases de Tableau nos vinieron genial y pudimos comunicar mediante un Storytelling realizado con Tableu el resultado final de nuestro proyecto.

La parte más difícil sin duda fue el tener que trabajar con un gran volumen de datos. Generalmente estamos acostumbrados a trabajar con ficheros de datos pequeños, pero cuando te enfrentas a más de cuatro gigabytes de datos sobre los que tienes que hacer agrupaciones, cálculos complejos y aplicar algoritmos, es entonces cuando tienes que hacer uso de tecnologías más avanzadas que nos obligaban a asumir nuevos retos, como tener que programar sobre datos de muestra y ejecutar el análisis sobre el conjunto final de datos sobre una arquitectura Big Data.

Por otra parte, siempre hemos valorado que un máster te obligue a la realización de un proyecto final. Es la mejor forma de poner en práctica lo aprendido y afianzar conocimientos. No sólo aplicas lo aprendido en clase sino que tienes que investigar y buscar soluciones a tus problemas.

Por ejemplo, utilizamos varias librerías de manipulación de datos, aplicamos diferentes algoritmos y experimentamos con diversos entornos como Cloudera o Hortonworks lo que nos ayudó a entender la complejidad que entraña cualquier proyecto de data science en cuanto trabajas con grandes volúmenes de datos.

Y no olvidemos el lado humano. Los proyectos dan lugar a muchas conversaciones que sirven para afianzar relaciones con todos los compañeros del máster y a echarnos unas risas.

Ahora que el máster ha finalizado, hemos podido aplicar en nuestros trabajos lo aprendido.

En mi caso concreto – José Ramón – hace tres años que trabajo como analista en El Arte de Medir y desde el primer día de clase he podido aportar soluciones basadas en los conocimientos adquiridos. Actualmente disfruto enfrentándome a nuevos retos transformando datos en conocimiento mediante técnicas que hasta entonces eran desconocidas.

Cada análisis supone un nuevo reto al que no me importa enfrentarme gracias a la amplia base de conocimientos adquirida en el máster.

Han sido muchas horas de clase, en las que hemos aprendido sobre linux, lenguaje SQL, python, R, modelos estadísticos y algoritmos de machine learning, álgebra matricial, visualización y todo impartido por un equipo de profesores high level, tanto en lo profesional como en lo personal.

Toca ahora repasar, aplicar los conocimientos adquiridos y seguir aprendiendo.

Si quieres acceder a todo el repositorio del proyecto de Jose Ramón y Marta y ver cómo han desarrollado cada parte de tu TFM para el Máster de Data Science, puedes hacerlo desde aquí.

El artículo A Data Science project in Banking Domain: TFM de José Ramón Cajide y Marta Cámara fue escrito el 6 de septiembre de 2016 y actualizado por última vez el 13 de diciembre de 2024 y guardado bajo la categoría Data Science. Puedes encontrar el post en el que hablamos sobre .

Esta formación te puede interesar

Programa Executive en People Analytics & HR Analytics

Crea y usa modelos efectivos en recursos humanos

Titulación conjunta con:

Nuestros cursos

Máster en Data Science

Domina las mejores técnicas de análisis de datos

Máster en Product Manager

Titulación conjunta con:

Descrubre nuestros cursos

16 · 12 · 2025

NumPy en Python: La clave para la ciencia de datos eficiente y el aprendizaje automático

Aprender NumPy es aprender a pensar en arrays y operaciones vectorizadas: una competencia que acelera análisis, mejora la interoperabilidad con herramientas del ecosistema y abre puertas en Data Science y Machine Learning. Te contamos en qué consiste, qué ventajas tiene y cómo puede ayudarte. NumPy en Python: la clave para la ciencia de datos eficiente […]

24 · 11 · 2025

La Arquitectura Transformer: el corazón de los modelos de Deep Learning modernos

¿Quieres saber cuál es el verdadero origen del avance de la IA en tan poco tiempo y de forma tan rápida? Pues la respuesta es la Arquitectura Trasnformer. Te contamos cómo funciona, en qué se basa y cómo puede ayudarte a comprender cuáles son los fundamentos básicos del Deep Learning moderno. ¿Qué son los Transformers […]

24 · 11 · 2025

Herramientas de business intelligence y su importancia para la toma de decisiones estratégicas

Para tomar las mejores decisiones y adaptarlas a la estrategia de tu empresa o negocio, es necesario que puedas apoyarte en datos que te proporcionen la información que necesitas. Te contamos cómo las herramientas de Business Intelligence pueden ayudarte con ello para que logres sacarles el máximo rendimiento. ¿Qué son las herramientas de business intelligence […]

24 · 11 · 2025

Apache Spark: potencia tu análisis de datos a gran escala

Apache Spark es una de las tecnologías más utilizadas en Big Data ya que permite el uso de datos en memoria, es compatible con distintos lenguajes y funciona a través de módulos lo que hace que la información se pueda procesar en segundos y se transforme en conocimiento. Te contamos qué es Apache Spark y […]